Жидкостное охлаждение вычислительных комплексов

СЕРГЕЙ АБРАМОВ директор Института программных систем имени А.К. Айламазяна Российской академии наук (РАН), член-корреспондент РАН, профессор, доктор физико-математических наук

СЕРГЕЙ АМЕЛЬКИН руководитель исследовательского центра системного анализа Института программных систем имени А.К. Айламазяна РАН, кандидат технических наук, старший научный сотрудник

ЛЕОНИД КЛЮЕВ генеральный директор ООО «ИММЕРС», кандидат технических наук

АЛЕКСАНДР ЧИЧКОВСКИЙ директор по развитию ООО «ИММЕРС»

Учитывая сочетание роста количества транзисторов с возрастающим их быстродействием в Intel сформулировали прогноз об удвоении производительности процессоров каждые 1,5 года. Однако потенциал компьютеров за прогнозом не спешил. К тому же развитие технологий снижало стоимость производства транзисторов, но каждые 4 года удваивало цену фабрик по их выпуску в соответствии с «законом Рока». Нужно было всеми способами резко увеличить продажи. И в 1965 году стали говорить об эмпирической зависимости, известной как «закон Мура», что количество транзисторов, которые можно разместить на кристалле интегральной схемы, будет удваиваться каждые 12 месяцев. На деле это был маркетинговый прием, потому что потом период достиг 24 месяцев и выдерживался достаточно долго.

С появлением высокоинтегрированных процессоров в архитектуру вычислительных комплексов (ВК) включали дополнительные процессоры, которые содержали логику, кеш, затем ОЗУ, регулятор мощности, аналоговые модули систем навигации, сотовой связи, Wi-Fi и микроэлектромеханические элементы, например, гироскопы и акселерометры. Новые технологические решения позволяют удерживать высокие темпы развития. При том же темпе совершенствования транспорта он стал бы субсветовым.

Но в процессоре нет механической работы и поступающая электроэнергия преобразуется в тепло. А его необходимо отводить. Интенсивность теплообмена пропорциональна площади поверхности и разности температур процессора и хладагента.

С возрастанием интенсивности вычислений, измеряемых в терафлопсах — 1012 операций в секунду, несмотря на изящную топологию, мощность тепловыделения транзисторов росла. И системы охлаждения (СО), имея ограничения по рассеиванию тепла, также ограничили максимальное создаваемое процессами количество тепла — TDP (Thermal Design Power).

Традиционное решение в СО — организация потока охлаждающего воздуха. От его скорости линейно зависят коэффициент теплообмена и интенсивность теплоотдачи с единицы площади при фиксированной разности температур. Физические пределы эффективности воздушной технологии охлаждения практически достигнуты. Снижать температуру, увеличивать скорость хладоагента, мощность вентиляторов и размеры радиаторов уже невозможно.

Эффективность энергопотребления учитывается показателем эффективности использования мощности PUE (Power usage effectiveness). Он равен отношению всей потребляемой ВК электрической мощности к мощности, поступающей непосредственно на вычислительные платы. Среднее значение PUE мощных ВК, охлаждаемых воздухом, достигло 1,7. С повышением вычислительной мощности процессоров СО становятся более энергозатратными. Это не зависит от режима вычислений или простоя ВК. Отвести и рассеять 1 кВт тепла непосредственно в рабочем помещении можно вентиляторами общей мощностью 100 Вт (соотношение 10: 1). Для утилизации 1 мВт тепла в окружающей среде или в драйкулерах (сухих градирнях) и градирнях требуется более 0,6 мВт (отношение 1: 0,6).

Другие значимые проблемы в традиционных воздушных СО:

- Сложная форма, абразивность, электрический заряд частиц пыли обусловили ее оседание на радиаторах, вентиляторах, процессорах и формирование устойчивой пылевой оболочки с хорошей теплоизоляцией, которая не поддается полному удалению.

- Очистка воздуха от пыли также энергозатратна.

- При хаотичном перемешивании потоков холодного и нагретого воздуха от большого количества процессоров в ВК усложняется контроль за их очисткой, в том числе в ходе регламентных работ.

- У ряда особенно чувствительных элементов, разъемов с повышением температуры и запыленности существенно ухудшаются параметры работы.

- Нарастание шума вентиляторов, особенно высокочастотного. Приемлемый уровень шума в машинном зале принят 73 дБ, и стандартами предусмотрены дополнительные меры и затраты по шумоизоляции. Вычислительный центр сегодня — это построенные и эксплуатируемые по специальным нормам капитальные помещения с очисткой, кондиционированием, циркуляцией, конвекцией воздуха для охлаждения процессоров и плат. Разработка энергосберегающих процессоров (CPU и GPU — графические процессоры) позволяет на каждый Ватт потребляемой мощности проводить все больше операций в секунду. Пять лет назад он составлял 0,2…1,0 Тфлопс/кВт, сейчас превышает 5,0 Тфлопс/кВт. Известны разработки процессоров эффективностью до 10,0 Тфлопс/кВт.

Рис. 1. Схема погружного охлаждения

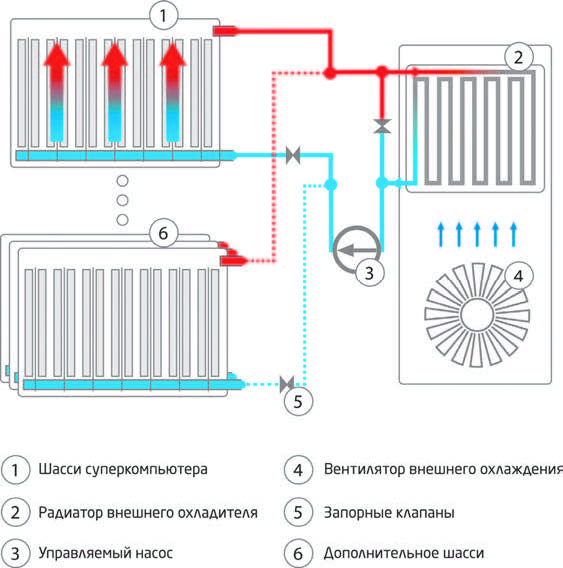

Количество процессоров и вычислительная мощность компьютеров растут экспоненциально, но реализация их возможностей и вычислительной производительности становится все затратнее. Улучшение качества процессоров и переход на иные принципы работы вычислителей не сопровождаются такими же по эффективности решениями по утилизации тепла с помощью вентиляции. Один из путей интенсификации охлаждения, это использование жидкого хладоагента. Коэффициент его теплоотдачи в сотни раз выше, чем у воздуха, что существенно ускоряет отведение тепла. В настоящее время развиваются следующие технологии охлаждения с использованием жидкостей:

- Контактное охлаждение — нагревающийся элемент электроники непосредственно контактирует с раствором дистиллированной воды с пропиленгликолем, исключающим коррозию. В зависимости от степени покрытия теплосъемными элементами материнской платы данный тип охлаждения может быть в двух вариантах:

- тепло снимается только с самых горячих компонентов — процессоров, видеокарт и сопроцессоров, тепловыделение которых ярко выражено;

- тепло отводится единым радиатором от единой материнской платы и располагающихся на ней процессорах, модулях памяти и остальных чипов.

- Погружной подход. Нагревающиеся компоненты полностью погружаются в жидкий теплоноситель, как, например, в масляных трансформаторах. В качестве рабочего тела используются диэлектрические жидкости — вода, минеральные или синтетические масла, безопасные для электроники и персонала.

Здесь тоже могут быть два варианта.

- общий герметичный контейнер, наполненный минеральным диэлектрическим маслом с теплоемкостью в 1200 раз большей, чем у воздуха, обеспечивающий нормальную работу серверов при температуре диэлектрической жидкости до +50 °С, которую можно охлаждать за счет более низкой температуры окружающей среды, что экономит электроэнергию. Эта технология одна из самых энергоэффективных. Так, решения IMMERS 6 R4 и 8 R5 компании ИММЕРС, российского разработчика решений для суперкомпьютерных вычислений, рассчитаны на отвод 12 и 18 кВт тепловой энергии соответственно, при уровне энергоэффективности PUE=1,037;

- каждый вычислительный модуль помещается в отдельный корпус, за исключением устройств памяти и коммутационных разъемов.

Кипящее, так называемое двухфазное охлаждение — нагрев жидкости до температуры кипения и парообразования. Для этого способа требуются специальные контейнеры и жидкости с низкой температурой кипения, приблизительно соответствующей температуре окружающей среды. В фазе кипения происходит особенно эффективный теплосъем, так, теплота парообразования в несколько выше теплоты, требуемой для нагрева.

Контактное охлаждение реализуется как закрытая система теплоотвода с использованием воды — одного из лучших хладоагентов. Она прокачивается по специальным каналам в замкнутом объеме металлических конструкций (пластин).

Металлические пластины, как и радиаторы в воздушных системах охлаждения, переносят тепло от процессоров к воде, а акже исключают контакт электрических компонентов вычислительных плат с хладагентом. Это позволяет использовать охлаждающие жидкости с высокой теплоемкостью вне зависимости от их свойств (агрессивность, электропроводность).

Высокая теплоемкость жидкости позволяет снизить скорость циркуляции и расход энергии на охлаждение. Такое жидкостное охлаждение нередко является компонентом гибридной системы охлаждения. Жидкостью охлаждается только процессор, выделяющий около 95 % всего тепла. Остальные платы охлаждаются воздухом. Вода в гибридные системы охлаждения может подаваться с температурой до +40°С, что позволит улучшить энергоэффективность вычислительного комплекса до 1,3 PUE и в некоторых случаях — до 1,15 PUE. Этот способ существенно эффективнее воздушного охлаждения, но тоже затратный, так как требует изготовления надежных охлаждающих конструкций, исключающих любые протечки. Он не избавляет от вентиляторов и шума потоков воздуха.

Охлаждение ВК в погружной СО требует меньше энергии. В отличие от закрытых систем, где требуется обеспечивать циркуляцию хладагента по трубам малого диаметра, жидкость в погружных системах может транспортироваться по трубам до 2 дюймов, а эффективный диаметр бака, в котором находятся погруженные в охлаждающую жидкость вычислительные платы, достаточно велик. Это значительно снижает гидравлическое сопротивление в системе подачи хладагента и энергозатраты на его циркуляцию. Для функционирования погружной СО требуется энергии в количестве менее 4 % от отводимого от процессоров тепла (PUE = 1,035). В самый жаркий день (+40°С) охлаждение ВК с энергопотреблением и тепловыделением в 50 кВт может быть организовано без использования холодильных машин, что неосуществимо при охлаждении воздухом.

Разность температур между процессорами и окружающим воздухом позволяет оценить возможности утилизации тепла у воздушных и жидкостных СО. В воздушных СО она составляет около 1,5 °С/кВт, что при мощности ВК в 50 кВт требует наличия холодильной установки. В жидкостных СО разность температур значительно меньше — до 0,5 °С/кВт, что даже при температурах +35 — +40 °С позволяет использовать технологии свободного охлаждения (фрикулинга).

Освобождение мощностей электропитания оказывается возможным потому, что погружная система охлаждения вычислительных комплексов является очень эффективной. Действительно, жидкость, нагревающаяся на 1 °С, отбирает в 4 000 раз больше тепла, чем такое же по объему количество воздуха, нагревающегося на 1 °С. Это означает не только, что интенсивность потока хладагента может быть уменьшена, но и то, что можно использовать теплую жидкость, в процессе охлаждения нагревающуюся лишь на 5–10 °С в зависимости от мощности охлаждаемых вычислительных устройств. Чем меньше скорость протекания хладагента, чем меньше разность температур, тем меньше энергии потребляет система охлаждения и вычислительный комплекс в целом. Проведенные исследования показали, что внедрение погружных технологий охлаждения вычислительных устройств позволит при существующих энергозатратах увеличить вычислительную мощность на 30–50 %.

Погружные СО позволяют не только существенно снизить энергозатраты на охлаждение, но и решают все остальные проблемы развития вычислительной техники: погружная система может быть выполнена в герметичном корпусе, герметичное исполнение не подвержено загрязнению пылью, при использовании погружной системы охлаждения ВК можно будет устанавливать в любом неподготовленном помещении и даже под навесом вне помещения; погружные системы не производят шума: вблизи вычислительного комплекса не надо будет кричать, достаточно тихо говорить — шум составляет только 40 дБ от работы насоса.

Развитие погружных СО позволит устанавливать высокопроизводительные ВК на заводах, на транспорте, использовать вычислительные мощности непосредственно там, где они нужны, вне зависимости от условий, климата и значительно расширит область их применения.

Эффективность погружного охлаждения позволяет увеличить плотность компоновки вычислительных устройств без снижения качества охлаждения. Плотность компоновки связана как с уменьшением расстояния между платами, так и с сокращением пространства на установку инженерного обеспечения ВК. В погружных системах не нужны ни межрядные кондиционеры, ни горячие и холодные коридоры, ни громоздкие гидросистемы. Отсутствие дополнительных шкафов (межрядных кондиционеров и пр.) и площадей (горячие коридоры и пр.) для обеспечения работы системы охлаждения позволит уменьшить площадь, занимаемую вычислительным комплексом, и мощность электропитания, что может быть

использовано для расширения ВК. Устанавливая погружную систему охлаждения, можно увеличить мощности вычислительного центра в 1,3–1,8 раза (в зависимости от существующей СО ко времени установки) даже при существующей плотности монтажа вычислительных плат.

В начале 2017 года компании ИММЕРС, ТЕСИС — разработчик программного комплекса FlowVision (численное моделирование задач гидро- и аэродинамики) и Арбайт — российский ИТ-интегратор, поставили отечественный программно-аппаратный комплекс (ПАК) Иммерс/FlowVision ТАНТК имени Г. М. Бериева для решения мультидисциплинарной задачи определения взлетно-посадочных характеристик самолета-амфибии.

Рис. 2. Вычислительный комплекс IMMERS 8 R5 с погружной системой охлаждения

В качестве вычислительной платформы ТАНТК имени Г. М. Бериева предпочли решение российской компании ИММЕРС, которая предложила расчетный кластер, уникальный по соотношению компактности, энергоэффективности и производительности. Компактность конструкции, низкий уровень шума и отсутствие специальных требований к помещению были определяющими при выборе вычислительного кластера ИММЕРС. Возможности, которые сегодня предоставляет ПАК ИММЕРС/FlowVision в области решения мультидисциплинарных задач, являются уникальными и позволяют разработчикам российской авиационной техники моделировать разнообразные режимы внешнего обтекания и внутренних течений газа и жидкостей. В ряду вычислительных кластеров, производимых компанией ИММЕРС, присутствуют модели, спроектированные для устойчивой работы в условиях вибрации и перегрузок.

В России ведется строительство высокопроизводительных вычислительных центров, объектов информационной структуры в авиационной, судостроительной и других отраслях промышленности, спроектированных под жидкостные СО. Необслуживаемые жидкостные СО могут найти применение в бортовых вычислительных системах летательных, космических аппаратов, автономных станциях метеонаблюдения, навигации. Отечественные решения, разработанные под нужды наших заказчиков, обеспечивают снижение энергопотребления, уменьшение требуемой площади под инженерную инфраструктуру, увеличение производительности и срока службы компонентов, снижение производственного шума.